TiDB原理與實戰 數據處理和存儲支持服務詳解

TiDB作為新一代開源分布式數據庫,通過獨特的架構設計實現了大數據存儲與處理的高效支持。在實戰應用中,其數據處理和存儲支持服務的核心原理和實現機制至關重要,本文將從原理和實戰角度深入解析。

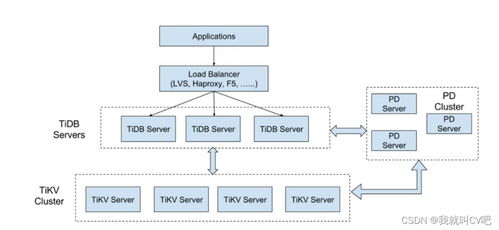

一、TiDB架構原理概述

TiDB采用分層架構,包括無狀態的計算層(TiDB Server)、分布式存儲層(TiKV)和集群管理組件(PD)。計算層負責SQL解析與優化,存儲層基于Raft協議保證數據強一致性,PD組件負責元數據管理與負載均衡。這種解耦設計使得TiDB具備水平擴展能力,可支撐PB級數據規模。

二、數據處理機制原理與實戰

- SQL處理流程:TiDB計算層首先解析SQL語句,生成邏輯執行計劃,再結合統計信息優化為物理執行計劃。實踐中,可通過EXPLAIN語句分析執行計劃,針對慢查詢進行索引優化或SQL重寫。

- 分布式事務處理:TiDB采用樂觀鎖機制,通過兩階段提交(2PC)保證ACID特性。實戰中需注意熱點更新問題,可通過分片鍵設計或批量操作優化事務性能。

- 數據分區與分片:TiKV將數據按Range劃分為多個Region,每個Region默認96MB。實際部署時,應預估數據量合理配置Region大小,避免頻繁分裂影響性能。

三、存儲支持服務原理與實戰

- 多副本與高可用:TiKV基于Raft協議實現數據多副本(默認3副本),任一節點故障不影響服務可用性。實戰中需確保網絡延遲穩定,跨機房部署時建議配置5副本以提高容災能力。

- 存儲引擎優化:TiKV底層使用RocksDB作為存儲引擎,采用LSM-Tree結構優化寫性能。實際運維中需監控Compaction壓力,適時調整壓縮策略避免寫放大。

- 混合負載支持:TiDB通過TiFlash提供列式存儲,支持實時分析查詢。實戰中可通過設置副本優先級,將OLAP查詢路由至TiFlash,實現HTAP混合負載隔離。

四、運維實戰要點

- 監控告警:通過TiDB Dashboard和Prometheus監控集群健康度,重點關注QPS、延遲、Region分布等指標。

- 備份恢復:使用BR(Backup & Restore)工具進行全量與增量備份,建議結合定時任務實現自動化災備。

- 版本升級:TiDB支持在線滾動升級,但需提前測試業務兼容性,建議在業務低峰期執行。

TiDB通過創新的分布式架構,為大數據場景提供了完善的數據處理和存儲支持服務。在實戰中,深入理解其原理并結合具體業務特點進行調優,可充分發揮其高可用、強一致和彈性擴展的優勢。

如若轉載,請注明出處:http://www.kh57.cn/product/24.html

更新時間:2026-01-08 20:02:17