從零到一建設數據中臺 數據處理與存儲支持關鍵技術匯總

在數字化轉型的浪潮中,數據中臺已成為企業實現數據驅動、釋放數據價值的核心引擎。其核心在于將分散、異構的數據資產進行統一整合、治理與加工,形成可復用、可共享的數據服務能力,從而高效賦能前端業務。從零到一建設數據中臺,數據處理與存儲支持服務是至關重要的技術基石。本文將系統梳理和匯總其中的關鍵技術環節。

一、核心數據處理技術

- 數據集成與同步

- 批處理與實時流處理:建設初期需兼顧存量數據的批量遷移與增量數據的實時接入。常用工具有Apache Sqoop、DataX(批處理),以及Apache Kafka、Flink、Spark Streaming(實時流處理)。它們確保了數據從源頭系統到中臺的穩定、高效流動。

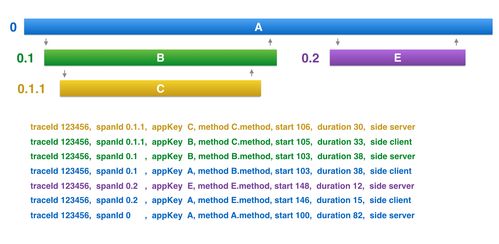

- CDC(變更數據捕獲):對于數據庫源,CDC技術(如Debezium、Canal)能夠低延遲地捕獲數據的新增、更新和刪除操作,是實現實時數據同步、保證數據一致性的關鍵技術。

- 數據開發與計算

- 離線計算:基于Hadoop MapReduce、Apache Spark、Hive等構建大規模數據倉庫,進行復雜的ETL(抽取、轉換、加載)作業、數據清洗、指標加工和報表生成。

- 實時計算:采用Apache Flink、Spark Streaming等流計算框架,對實時數據流進行即時處理與分析,滿足實時監控、實時推薦等業務場景。

- 交互式查詢:利用Presto、ClickHouse、Apache Kylin等引擎,支持對海量數據的亞秒級到秒級的多維分析查詢,提升數據探索與分析的效率。

- 數據治理與質量

- 元數據管理:建立統一的數據地圖,自動采集技術元數據(如表結構、血緣關系)和業務元數據(如指標口徑、業務術語),實現數據的可發現、可理解與可追溯。工具如Apache Atlas、DataHub。

- 數據質量:通過定義并監控數據的完整性、準確性、一致性、及時性等規則,構建數據質量閉環。工具如Griffin、Apache Griffin或自研平臺。

- 數據標準與建模:制定企業級的數據標準與規范,并采用維度建模(如Kimball模型)或數據倉庫模型,構建清晰、穩定的數據公共層(如貼源層、公共維度層、匯總層),這是數據資產可復用的核心。

二、核心數據存儲技術

- 統一存儲層

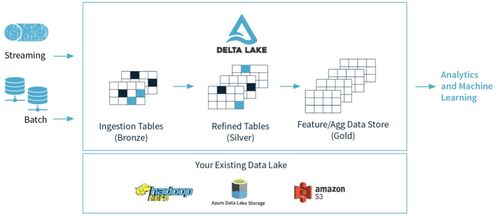

- 數據湖:以Apache HDFS、AWS S3、阿里云OSS等對象存儲為核心,構建企業級數據湖,用于原始、全量數據的低成本、高可靠存儲。它接納各種格式(結構化、半結構化、非結構化)的數據,為上層計算提供統一的“水源”。

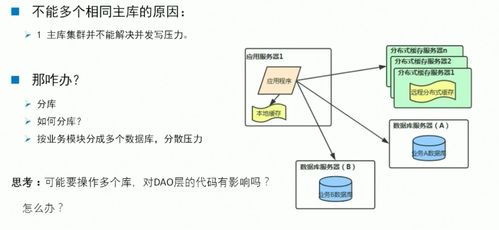

- 數據倉庫:在數據湖之上,基于Hive、Iceberg、Hudi或云上數倉產品(如MaxCompute、Snowflake),構建結構清晰、模型規范的數據倉庫,服務于系統性的分析與決策。

- 多樣化存儲引擎

- OLAP分析型存儲:針對不同的查詢模式,選擇合適的列式存儲引擎,如ClickHouse(極致查詢性能)、Apache Doris(兼顧實時與離線)、StarRocks等,以支持高速多維分析。

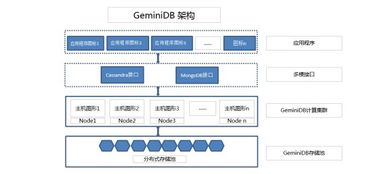

- NoSQL與寬表存儲:對于高并發點查、靈活Schema或時序數據場景,需引入HBase、Cassandra、MongoDB、時序數據庫(如InfluxDB、TDengine)等作為補充。

- 圖數據庫:對于關系挖掘、社交網絡、風控等場景,Neo4j、Nebula Graph等圖數據庫能高效處理復雜的關聯查詢。

三、支持服務與平臺化

- 任務調度與運維

- 采用如Apache DolphinScheduler、Airflow等調度系統,對復雜的ETL任務流進行可視化編排、依賴管理與監控告警,保障數據處理作業的穩定運行。

- 數據服務與API化

- 建設統一的數據服務網關,將加工好的數據(如維度表、指標、用戶畫像標簽)封裝成標準、安全的API(Restful、GraphQL),供業務系統低門檻、高性能地調用,這是數據中臺價值輸出的最后一公里。

- 安全與權限

- 實施貫穿數據全生命周期的安全策略,包括存儲加密、傳輸加密、細粒度的數據訪問控制(基于RBAC或ABAC模型)、數據脫敏與審計日志,確保數據安全合規使用。

###

從零到一建設數據中臺,數據處理與存儲支持服務是貫穿始終的技術主線。企業需要根據自身的數據規模、業務場景、技術棧和團隊能力,合理選擇和組合上述關鍵技術,并注重其平臺化、服務化與自動化。關鍵在于以終為始,圍繞“數據資產化、服務化”的核心目標,構建一個靈活、高效、可信的數據基礎設施,從而穩步支撐起企業數據能力的持續演進與業務創新的加速實現。

如若轉載,請注明出處:http://www.kh57.cn/product/64.html

更新時間:2026-01-08 08:00:50